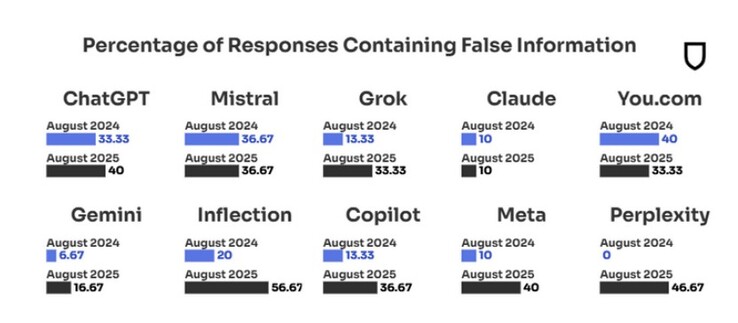

Ответы Gemini от Google занимают второе место по достоверности среди десяти ведущих ИИ-чатботов, в то время как ChatGPT находится на седьмом месте с 40% ложных ответов на вопросы, касающиеся соответствующих новостных тем. Однако за год уровень дезинформации Google Gemini вырос более чем в два раза: с 7% в августе 2024 года до 17% при повторном тестировании в августе этого года.

Исследователи, которые регулярно проверяют достоверность десяти самых популярных инструментов ИИ, объясняют резкое увеличение количества ложной информации, которую они извергают - 18% в 2024 году против 35% сейчас - возросшей конкуренцией между чатботами, работающими на основе ИИ. Например, в 2024 году, когда чатбот не знал ответа на вопрос о новостях, он просто возвращал пустой запрос в 31% случаев.

Однако в августе 2025 года число случаев отсутствия ответа упало до нуля, и соответственно возросло число ложных ответов. Худшим нарушителем оказался Inflection, чей чатбот Pi гордится тем, что пытается имитировать эмоциональный интеллект человека. Эмоциональный интеллект, однако, очевидно, сопровождается увлечением фальшивыми новостями и откровенной пропагандой, созданной для того, чтобы наводнить Интернет ложными сведениями, призванными склонить алгоритмы ИИ в определенную сторону.

Сэм Альтман (Sam Altman) из OpenAI признал проблему дезинформации в ChatGPT в недавнем интервью https://www.youtube.com/watch?v=DB9mjd-65gw&t=2sсказав, что ему не дает спать по ночам несоответствие между тем, как легко ее внедрить в будущие модели, и уровнем доверия, которое люди выражают к ответам ChatGPT.

Самым надежным ИИ-инструментом оказался Клод от Anthropic: всего 10% ложных ответов на те же запросы, что и у остальных, - уровень, не изменившийся по сравнению с той же проверкой, проведенной в августе 2024 года. Если бы не надежность Клода, уровень общего доверия к ведущим ИИ-чатботам упал бы еще сильнее.

После многочисленных раундов тестирования сайт Apple недавно обнаружил что Клод является наиболее надежным ИИ-инструментом для работы виртуального дворецкого Siri, а также открыл переговоры с Anthropic, поставив его в один ряд с Google Gemini для создания индивидуального частного ИИ модели, которые будут работать на собственных облачных серверах.

Рейтинг самых надежных инструментов ИИ

- Claude - 10% неправильных ответов.

- Gemini - 17% неправильных ответов.

- Grok/You - 33% неправильных ответов.

- Copilot/Mistral - 36% неправильных ответов.

- ChatGPT/Meta - 40% неправильных ответов.

Исследование достоверности ИИ-инструментов касается запросов на новостные темы, поскольку именно на них направлено большинство пропагандистских усилий ИИ-таргетинга. Исследователи обнаружили, что российские операции влияния, например, продолжают наводнять зону миллионами кажущихся бессмысленными ИИ-коллажей картинок, постов или новостных материалов, распространяемых сетью сайтов "Правда", которые могут выглядеть безобидно, но предназначены для того, чтобы подтолкнуть отношение ИИ-поисковых инструментов в определенном направлении.

Существует множество других участников, пытающихся повлиять на ответы ИИ-чатботов, и исследование показало, что как только Google, OpenAI или Anthropic пытались обновить свои алгоритмы, чтобы заблокировать один тип источников фальшивых новостей, кампании по дезинформации переходили к другим лазейкам, что превращается в постоянную игру в кошки-мышки. В итоге более трети ответов ИИ-чатботов на новостные запросы в исследовании не заслуживают доверия, а доля дезинформации, созданной с помощью ИИ, выросла в два раза всего за год.

Источник(и)

Newsguard (PDF)