Бесплатный, открытый DeepSeek V3.2 Exp AI LLM дебютирует с более низкой стоимостью вычислений, помогая предприятиям сэкономить еще больше денег

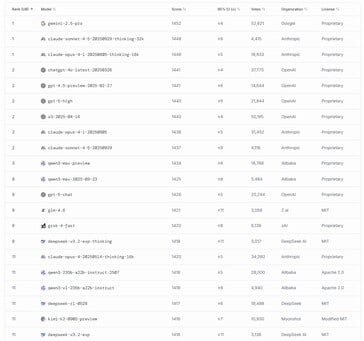

Компания DeepSeek выпустила свою последнюю крупноязычную модель искусственного интеллекта DeepSeek-V3.2-Exp со значительно сниженными вычислительными затратами. Эта оптимизация помогает компаниям, использующим API компании в своих приложениях, экономить деньги, предоставляя доступ к интеллектуальному ИИ, который занял 11-е место среди самых мощных LLM, выпущенных в мире.

Этого удалось достичь благодаря использованию новой конструкции DeepSeek Sparse Attention (DSA), которая фокусируется на индексации лексем не с каждой второй лексемой, как в случае с традиционными ИИ-трансформаторами, а только с самыми релевантными. Это позволяет ИИ быстрее обрабатывать входной текст вплоть до окна в 128K токенов при меньших затратах памяти.

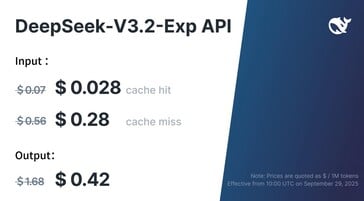

Разработчики приложений, получающие доступ к DeepSeek V3.2 Exp через его публичный API, могут рассчитывать на то, что они заплатят более чем на 50% меньше, чем за предыдущую версию, при сохранении сопоставимой производительности в стандартизированных бенчмарках ИИ.

С сайта Hugging Face можно бесплатно загрузить 400 ГБ AI LLM и запустить локально на мощных компьютерах. Читателям, которые это сделают, понадобится система с несколькими Nvidia H100/H200/H20 GPU или один NVIDIA B200/GB200, как минимум, из-за требований модели к 1,5+ ТБ VRAM.

Читателям, которые хотят запустить DeepSeek v3.2 на домашних компьютерах, придется дождаться выхода квантованных моделей на Hugging Face, , как, например, эта модель для v3.1 от unslothи иметь графический процессор с не менее чем 24 ГБ памяти, например, этот Nvidia 5090 на Amazon.