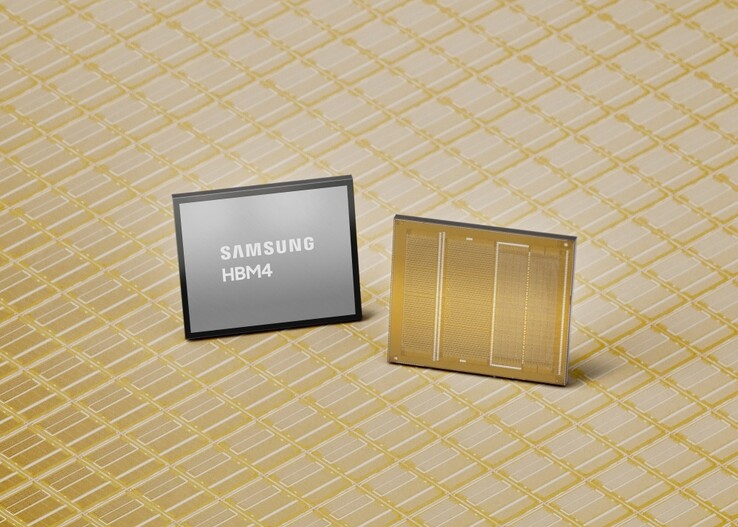

Samsung поставляет самую дорогую ИИ-память, которую когда-либо заказывала Nvidia, поскольку HBM4 превосходит ключевые характеристики

Компания Samsung объявила о первых коммерческих поставках памяти нового поколения HBM4 для таких приложений, как графические процессоры Nvidia и соответствующие центры обработки данных искусственного интеллекта.

Сообщается, что Nvidia и другие клиенты платят samsung около 500 долларов за штуку, что вдвое больше, чем они платили за предыдущее поколение памяти с высокой пропускной способностью HBM3E. Как следствие, акции компании Samsung достигли исторического максимума, а ее руководство ожидает еще один год блокбастеров, опираясь на общий дефицит памяти дефицита.

Технические характеристики памяти Samsung HBM4

В то время как производители памяти в настоящее время берут деньги за любую произведенную единицу, компания Samsung утверждает, что ее новая память HBM4 AI смогла превзойти как стандарт Объединенного совета по разработке электронных устройств (JEDEC), так и требования компании Nvidia.

Рабочая скорость HBM4 может достигать внушительных 13 Гбит/с, что на 46% выше требований JEDEC, а общая пропускная способность памяти достигает 3,3 ТБ/с на стек, что значительно превышает требования таких клиентов, как Nvidia, в 3 ТБ/с.

Компания Samsung добилась такой высокой пропускной способности благодаря преимущественному применению 10-нм техпроцесса 6-го поколения 1c DRAM с базовой матрицей, изготовленной по 4-нм технологии, в отличие от 14-нм 1a DRAM, который использовался для предшественника HBM3. Это дает поколению памяти HBM4 AI много возможностей для улучшения технологического процесса и производительности. Чтобы справиться с выделением тепла, Samsung разработала базовую матрицу и передачу данных с использованием технологий низкого энергопотребления и низкого напряжения, что позволило на 30% улучшить теплоотвод и на 40% повысить энергоэффективность по сравнению с памятью поколения HBM3, которую Nvidia сейчас использует в своих AI видеокартах серии Blackwell.

На данный момент Samsung может поставлять покупателям максимум 36 Гб памяти HBM4 в 12-слойном стеке, но она также может использовать 16-слойное стекирование для общего объема 48 Гб, когда Nvidia будет готова к соответствующему дизайну GPU и покупательной способности. Samsung обещает достаточное количество дорогих чипов HBM4, заявляя, что"продолжит обеспечивать стабильные поставки для удовлетворения растущего средне- и долгосрочного спроса, особенно со стороны искусственного интеллекта и центров обработки данных", когда начнутся продажи памяти следующего поколения HBM4E во второй половине 2026 года.

Приобретите комплект памяти 64GB Crucial DDR5 для ноутбуков на Amazon